ollama安装包纯净版是一款能在本地部署大语言模型的工具,由Ollama团队开发,不是Facebook那家公司做的。它内置了不少模型,像Llama、DeepSeek这些都能用,也能导入本地模型文件,不过得先写个配置文件,不能直接拖进去。操作起来也非常的简单,按步骤操作就行,适合想自己鼓捣大模型的小伙伴。

ollama安装包纯净版安装教程

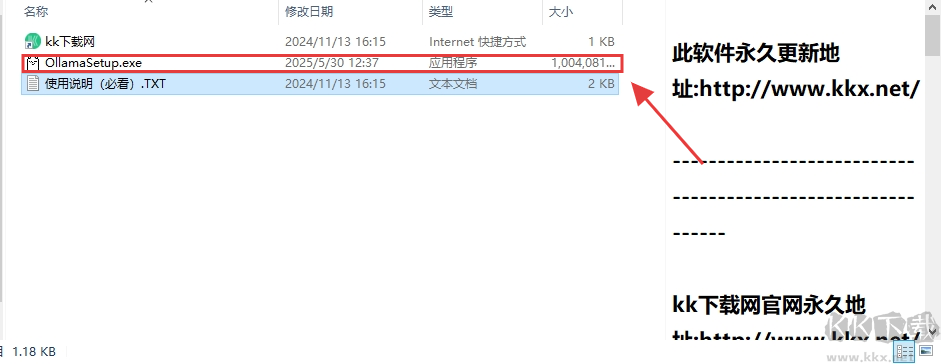

1、解压安装包后,找到并运行 ollamasetup.exe 程序。

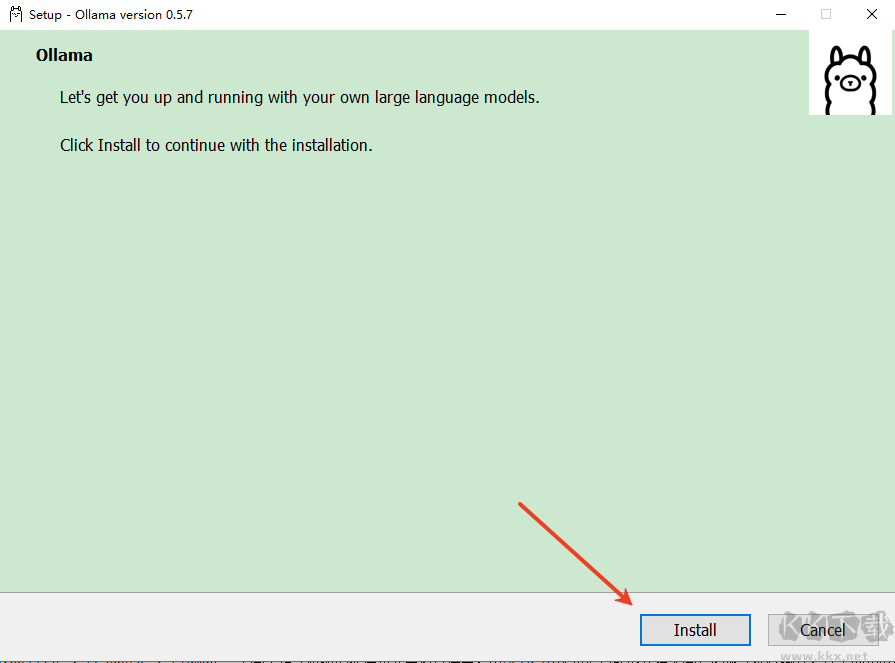

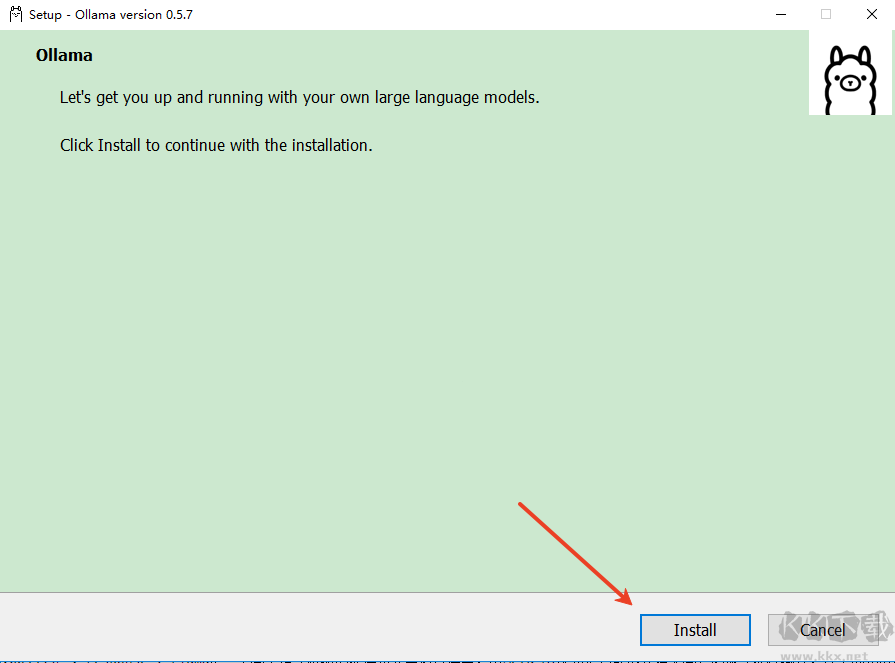

2、弹出安全警告窗口时,点击 “运行” 继续安装。

3、进入安装界面,点击 “install” 按钮,等待片刻完成安装。

ollama 安装包纯净版本地部署教程

1、若搭配 DeepSeek 模型,根据电脑配置选版本(如 1.5b、7b 等,版本越高对 GPU 要求越高)。

2、复制对应版本安装命令(例:DeepSeek-R1-Distill-Qwen-1.5B 对应 ollama run deepseek-r1:1.5b)。

3、打开 CMD 命令框,输入命令(如 ollama run deepseek-r1:1.5b),自动在线部署。

4、部署成功后,可在命令窗口输入问题与模型交互。

ollama 安装包纯净版功能

API 与多语言支持

1、REST API:兼容 OpenAI 接口,通过 /api/generate 和 /api/chat 生成文本或对话。

2、客户端集成:支持 Python、Java、C# 等语言调用,便于集成至 Web 或桌面应用。

硬件加速与资源优化

1、GPU 加速:在支持 CUDA 或 Metal 的设备上,利用 GPU 提升推理速度。

2、资源管理:通过环境变量(如 OLLAMA_KEEP_ALIVE、OLLAMA_MAX_VRAM)优化内存和显存占用。

本地化部署

1、支持 macOS、Linux 和 Windows(预览版),可通过 Docker 或安装包部署,保障数据隐私与低延迟。

模型管理便捷

1、模型仓库:提供 Llama3、Phi3、Gemma2 等预构建模型,通过 ollama pull 快速下载。

2、自定义模型:通过 Modelfile 定义参数(如温度值、系统提示),创建个性化模型(如指定角色回答)。

3、多模型并行:支持同时加载多个模型,调整 num_ctx 控制上下文长度。

ollama 安装包纯净版本地部署配置要求

硬件要求

1、内存:最低 8GB,推荐 16GB 及以上。

2、显卡:支持 NVIDIA(30/40 系列)或 AMD(T4、V100、A10 等),显存至少 8GB。

3、处理器:最低 8 核,推荐 16 核及以上。

4、存储:至少 100GB 可用空间。

软件依赖

1、Docker(部分功能需支持)。

2、Python(用于高级开发)。

ollama 安装包纯净版应用场景

1、企业知识库与 RAG 应用:结合检索增强生成技术,本地处理敏感数据(如通过 Ollama RAG Chatbot 与本地 PDF 交互)。

2、多模态与代码生成:支持 LLaVA 分析图像,或通过 CodeLlama 生成代码片段。

3、本地对话与开发测试:通过命令行(如 ollama run llama3)或 Web 客户端(LobeChat、OpenWebUI)实现可视化交互。